Daher ist in der letzten Zeit die Entwicklung spezialisierter Deep-Learning-Hardware in den Fokus getreten. Neue Chip- und Speicherarchitekturen sollen zukünftig den Einsatz performanter und zu gleich energiesparender Hardwaremodule ermöglichen und so den Einsatz von Deep Learning in z.B. autonomen Fahrzeugen, Mobiltelefonen oder integrierten Produktionssteuerungen ermöglichen.

Lernen erfordert keine hohe Präzision in der Zahldarstellung

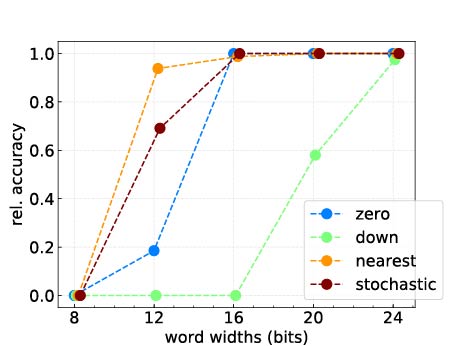

Dabei nutzt man eine wesentliche mathematische Eigenschaft des Deep Learning aus: Das Lernen und Auswerten von Modellen lässt sich auf die numerische Berechnung einer recht kleinen Anzahl von Operationen aus der Tensor-Algebra (wie z.B. Matrixmultiplikationen) reduzieren. Außerdem kommt man bei der Tensor-Berechnung mit einer deutlich geringeren Genauigkeit in der Zahldarstellung aus, als man dies typischerweise von physikalischen Simulationen gewohnt ist. Diese Eigenschaften ermöglichen nun eine – im Vergleich zu allgemeinen Recheneinheiten wie CPUs und GPUs – hocheffiziente Hardwareumsetzung.

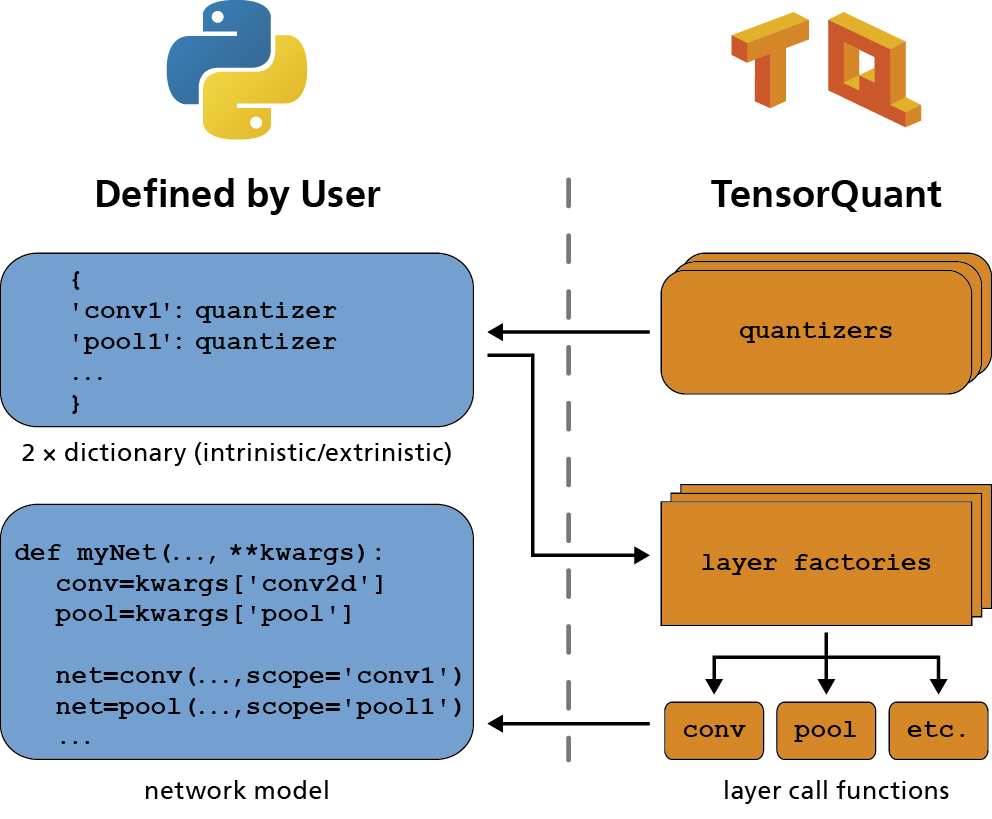

TensorQuant erlaubt die Simulation von Machine Learning Hardware

Bei der Entwicklung von Deep-Learning- Anwendungen auf spezialisierter Hardware ergibt sich die Schwierigkeit, dass die Mindestanforderungen an die Rechengenauigkeit zwischen einzelnen Modellen stark variieren. Dies macht die gleichzeitige Optimierung von Deep-Learning-Modellen und Hardware bezüglich Rechenperformanz, Energieverbrauch und Vorhersagegenauigkeit schwierig. Mit unserem am »Competence Center High Performance Computing« entwickelten Softwaretool TensorQuant (TQ) haben Entwickler nun die Möglichkeit Deep-Learning-Modelle mit beliebigen Zahldarstellungen und Rechengenauigkeiten zu emulieren, kritische Tensor-Operationen zu identifizieren und somit diesen Entwicklungsschritt deutlich zu beschleunigen. So wird TensorQuant bereits in Kooperationsprojekten mit der Automobilindustrie eingesetzt.