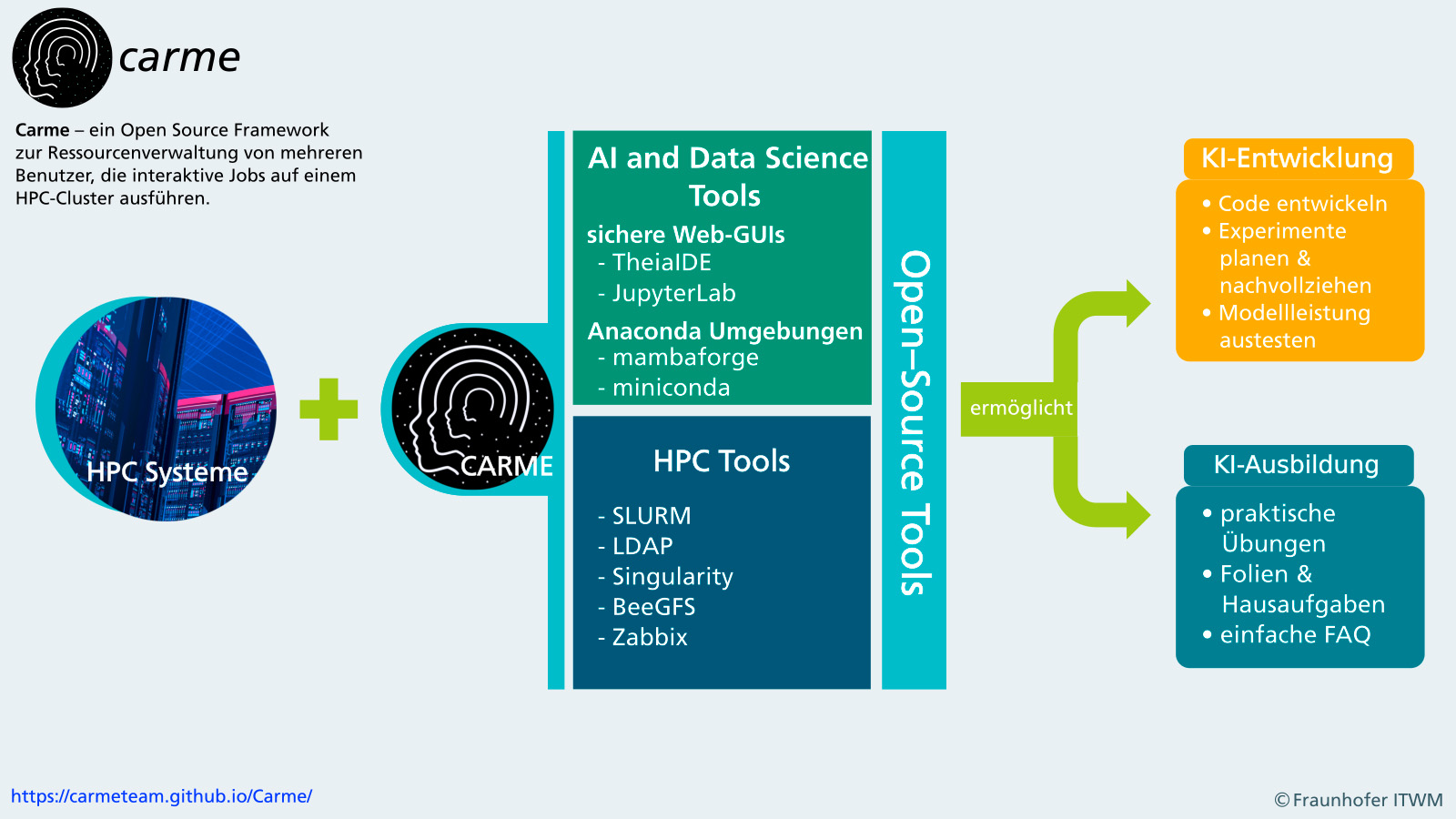

Carme verbindet die Welt des Maschinellen Lernens und die von HPC-Clustern

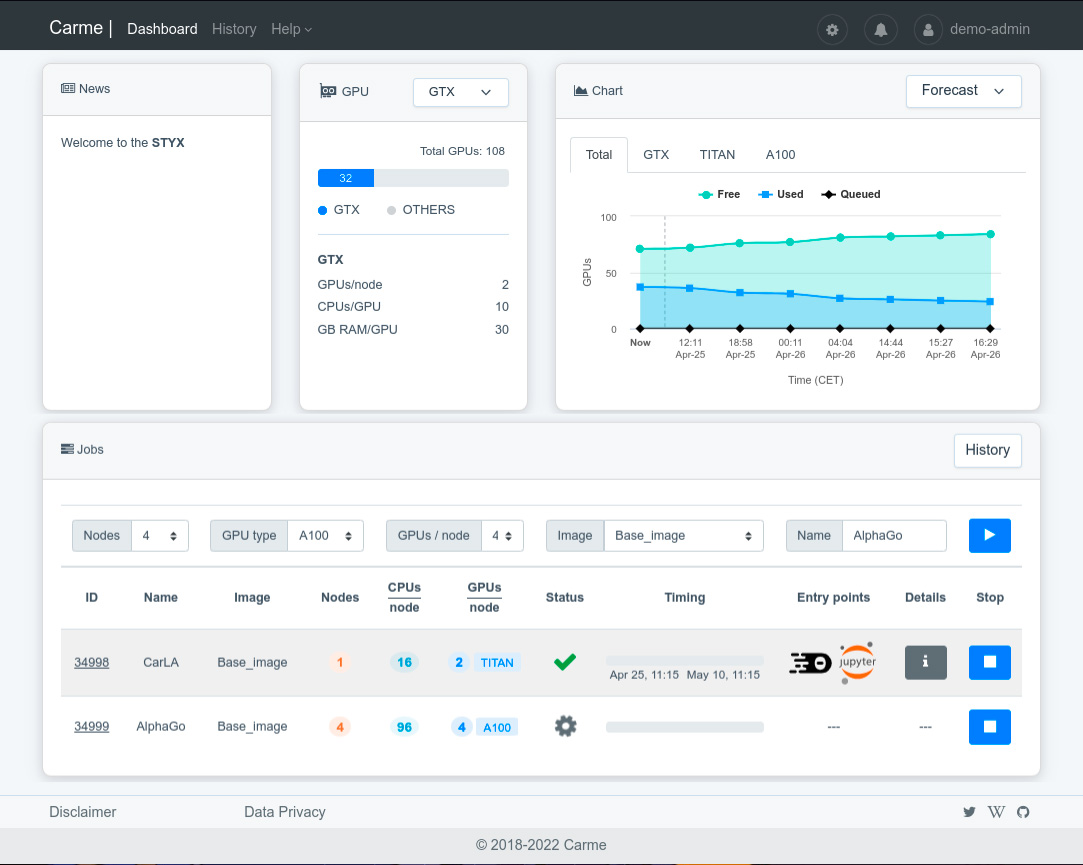

Machine Learning ist ein stetig und schnell wachsender Bereich. Diese Agilität stellt Rechenzentren vor die Herausforderung, sehr unterschiedliche Anwendungen für einzelne User bereitzustellen. Dabei sind die Anforderungen stetig neue Software und Bibliotheken in dem Maße auf HPC-Systemen noch nie vorgekommen. Damit verbunden ist die Tatsache, dass diese Bibliotheken meist nicht über das Linuxsystem sondern über Python-Umgebungen installiert werden müssen. Es ist auch nicht ungewöhnlich, dass verschiedene Deep Learning Algorithmen sich ausschließende Abhängigkeiten besitzen. In Carme setzen wir zur Lösung dieser Probleme auf Software-Container. Das erleichtert die Wartung für Administatoren und die Verwendbarkeit für Nutzer. Zudem ist die Nutzung von interaktiven Entwicklungsoberflächen im Bereich Deep Learning und Datenanalyse allgegenwärtig. Mit der Integration einer interaktiven Clusternutzung erhalten die Nutzenden die Chance, auf einem komplexen HPC-Cluster bereits bekannte Tools zu verwenden. Das erleichtert den Umstieg und den Einsatz eines Clusters.

Somit reicht es nicht aus Benutzeroberflächen und Bibliotheken bereit zu stellen. Es muss darüber hinaus eine reibungslose Integration dieser in vorhandene und entstehende Cluster gegeben sein. Eine intuitive Softwareumgebung auf den Clustern erhöht die Benutzerfreundlichkeit für alle NutzerInnen.